奔驰中国首位本土CEO功成身退,段建军奔向下一站

来源:汽车商业评论(朱琳)2022-02-11 23:05

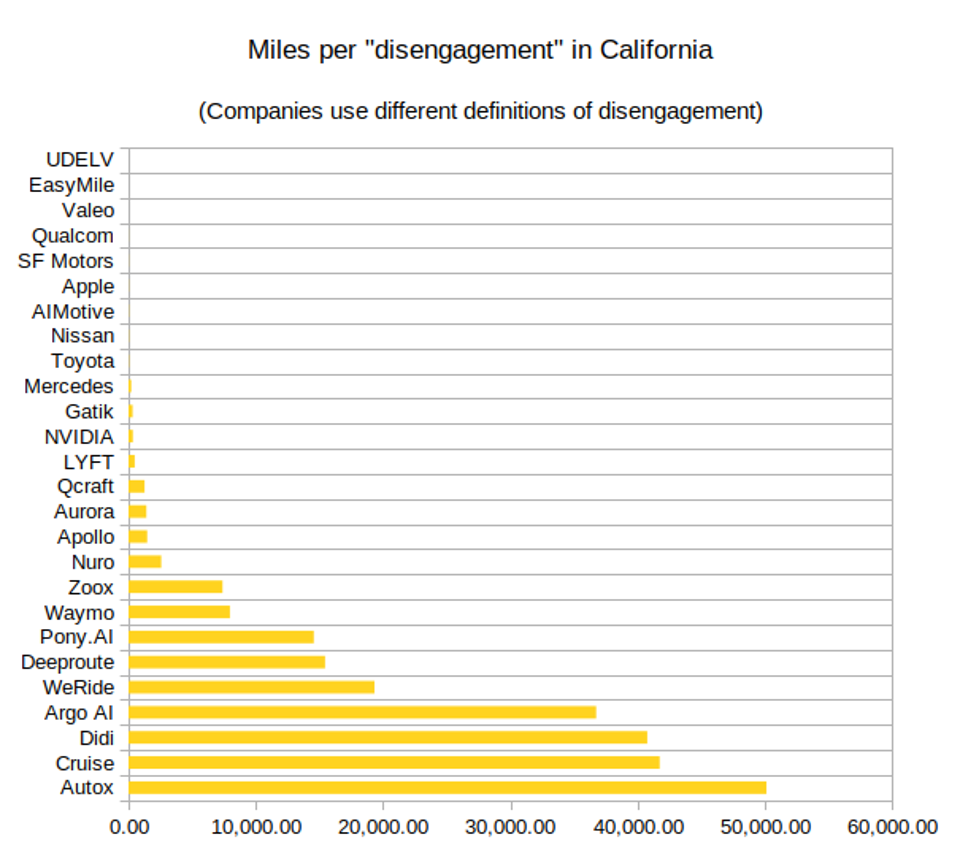

每年,加州机动车管理局都会发布一份《自动驾驶汽车脱离报告》(Autonomous Vehicle Disengagement Reports),这涉及所有在加州测试自动驾驶汽车系统的各家公司,报告他们的系统需要“脱离”的所有次数。导致这些“脱离”的原因,要么是由人类安全驾驶员决定的安全原因,要么是因为软件检测到一个问题并要求安全驾驶员接管。

以下是加州机动车管理局对脱离的定义:“脱离”指的是出于以下两种情况,停用自动驾驶模式:一是当检测到自动驾驶技术出现故障,或者出于汽车安全运行的目的,车上测试司机需停止自动驾驶模式,并立即接管车辆进行手动控制;二是在没有司机的情况下,出于汽车、车上乘员或公众安全原因,要求停用自动驾驶技术。

因此,每个自动驾驶技术团队可以计算出在每次脱离之间行驶了多少英里。每年,这个结果都不是很有用,因为对于一个团队需要什么条件来归类为一次脱离,有太多变量。

安全司机被告知,如果他们对安全风险有任何担心,就要进行脱离操作,但常常他们这么做了,而实际上却并没有什么真正的安全问题。更复杂的团队会在模拟器中重建这种情形,来找出如果司机没有进行介入的话,可能会发生什么。

许多其他的脱离发生的条件是,当软件检测到一个缺陷,并决定让安全司机接管时。好的软件充满了内部自我测试,这可以保证没有任何异常继续发生,它会发出许多不同级别的警告——这种情况是经常发生并且很常见的。

这些警告的大多数并不严重,但团队可以决定哪些是严重到需要让软件放弃驾驶的。另外,测试可能显示,许多这些软件的脱离可能并无必要,但是依据法律,它们也必须上报。

在上图中,那些每次脱离间行驶了2000英里以上的团队,可能只分离出了那些真正涉及安全的脱离情况。那些低于2000英里的团队可能不是这么做的,但我们没有从那些公司得到他们做法的细节。这样一来,就很难说一家公司比另一家公司好,尽管这些有更低数字的公司,可以被归类为尚未成熟的项目。

一个非常大的变化是Waymo的数据大幅下降。他们报告说,这是因为他们改用了基于捷豹汽车的新平台,尽管这也与他们将运营从硅谷转到旧金山有关,而旧金山的交通环境更为复杂。由于Waymo转移了平台,我们无法衡量旧金山比硅谷的困难多多少,这可能也是很有趣的一个因素。

Waymo报告了发生在旧金山的23起碰撞事故,所有事故都是轻微的,只有极少数司机受了轻伤(他们可以立刻回到工作岗位上)。在法律规定的标准下,Waymo没有过错,它拒绝回答在这些事故中是否有过错。

在亚利桑那,Waymo公布了一份报告,称在其汽车超过600万英里的行驶中,它们在任何实际和模拟的碰撞中它们都没有过错。在270万英里行程中发生23起碰撞事件,这也与一些预估比例相符(也包括来自Waymo自己的预估),这里指的是人类司机导致轻微事故的发生比例。

这次报告对Cruise来说是个好消息,它每次脱离之间的行驶距离从3万英里上升到了4万英里。我们可以推测它们的归类方法跟原来一样,但可能与Waymo的不同。

事实上,我们还可以推测,它们对其车辆在新夜间Robotaxi服务区域的处理能力更有信心,该区域的服务没有安全司机,并将不久后向公众开放。如果每行驶4万公里出现了一起真正的安全事故(比如车祸),它们就不太可能会对公众开启那片区域。

Cruise也是少数几个行驶里程中包含无安全司机部分的公司之一。它报告说,在这6400英里无安全司机的里程中,没有出现脱离,这是很好的。

车上没有安全司机,意味着唯一的脱离类型将会是来自远程操作中心的远程停止命令,或者是软件故障通知。这会通常会导致汽车快速停止,远程操作中心可能会给它建议,告诉它怎么做。你根本不会希望这种事情经常发生。

只有4家公司报告了含有无安全司机的行驶里程数,它们是:Cruise、Apollo、Nuro和小马智行。小马智行出现了一次脱离(和轻微的单一车辆事故),它们的许可被取消了。事实是,在你即将进入生产阶段之前,是没有理由在无安全司机的情况下运行的。

无安全司机行驶可以帮你为生产做好准备,并学习如何与乘客打交道,但它并不会教你如何更安全。Waymo在加州有一个许可证,但还没有使用。他们在亚利桑那州做了很多无司机的操作。

AutoX展示了一个从2万英里到5万英里的巨大飞跃。我们不知道它们是否使用了同样的归类方法。他们行驶的总里程非常少,并且不是在旧金山市中心。许多其他公司的数据也显示出大幅跳升。

粗略的数据显示,人类司机(整个美国范围内)每10万英里出现一次轻微剐蹭,每25万英里出现一次保险索赔,每50万英里出现一次警察报告的事故。

如果这些数字是为了避免事故而出现的干预数字,它们将完全达不到人类的水平。但它们正在向人类水平接近,这是一个好兆头。

事实上,真正的数字会比我们看到的更好,因为无论如何,它们肯定会要求报告事故,或者报告为了避免出现事故而出现的干预情况。

这些数字能够如此接近人类水平,意味着这些团队中有不少已经准备好部署了。虽然一些人希望看到自动驾驶系统能够与人类类似或者比人类做得更好,但这会推迟部署,也会推迟成熟业务的到来。

等到业务成熟的时候,也就是许多年以后,这些汽车会比人类好得多,路上会有许多自动驾驶汽车,大大地减少道路上的风险。

既然我们让有风险的青少年司机上路开车,让他们通过学习成为安全的成人司机,我们也需要对自动驾驶汽车做同样的事情,只是相比之下,这种回报绝对是巨大的。用现在的一点点额外风险来换取未来减少一百万倍的风险,不应该是一个困难的决定。

关于加州测试法案,没有人知道很多,但他们希望这些团队有一些责任来报告他们的安全数字。安全司机系统运行得非常顺利(在加州发生任何事故都是极其罕见的),汽车正在犯错误,对于原型车来说这是符合预期的,而安全司机正是在防止这些错误对公众造成风险。

要找到一个衡量方式,确保公司不会去造假,或者为了提高分数去承担风险,这是一个很艰巨的挑战。你希望这些公司告诉安全司机“如果发生任何看起来可怕的事情就要脱离”,而不会希望因为他们太过谨慎而惩罚他们。

如果必须对脱离进行分类,以下方法可能有用:

车辆做了一件危险的事情,模拟显示它导致了接触事件(按接触的严重程度分类)

车辆做了一件危险的事情,模拟显示它导致了违反道路规则,但没有接触

软件故障导致脱离发生,模拟显示上述情况之一

车辆过于谨慎,实际上阻碍了交通

车辆过于谨慎,但没有阻碍交通

车辆无法执行功能,所以不能进行脱离

安全驾驶员很担心,但模拟显示担心是错误的

安全驾驶员正在休息或正在开始新的任务

即便如此,如果没有审计,也很难确保每个人的衡量标准相同。而现实是,虽然我们很好奇,但政府关注的是保护公众的安全,而不是窥视团队的内部情况。只要没有人受到伤害,政府的目的就达到了。

大家都注意到了特斯拉的缺席。特斯拉声称他们不在加州测试自动驾驶车辆。当然,他们在推广一种他们称之为“完全自动驾驶测试版”(Full Self Driving Beta)的产品。但在细则中,以及对政府而言,他们称其为驾驶辅助系统。这在一定程度上,是事实。

特斯拉FSD测试版(真正的原型系统)确实需要全时段监督。而几乎所有其他团队也是如此,这就是为什么他们有自己的安全司机。法律豁免了对驾驶辅助系统报告和许可的要求,但这并不是要成为一个漏洞,让任何人都可以驾驶任何车辆。

事实上,当优步试图利用同样的漏洞时,加州车管局迫使它放弃了。车管局说,区别不在于你是否有监督,而在于你想制造什么产品。有传言说,他们可能会对特斯拉适用同样的规定,尽管可能的结果只是基于客户的原型测试在加州被关闭。

根据对特斯拉FSD运行的许多视频的评估,以及笔者自己的使用情况,粗略估计,他们的每次干预里程数将是图表上较差的数字,但目前没有办法告诉客户哪些干预是必需的,哪些是过于谨慎的。

附:加州自动驾驶汽车脱离报告下载地址:https://www.dmv.ca.gov/portal/vehicle-industry-services/autonomous-vehicles/disengagement-reports/